Codziennie prawie spotykam się z niezrozumieniem, czym jest AI. Ogrom osób nie widzi różnic w pojęciach asystent i agent, ani pomiędzy modelem a aplikacją. Wiele firm i osób, nie rozumiejąc poszczególnych terminów oraz sposobu działania technologii związanych z AI, podejmuje złe decyzje biznesowe. Kończy się to ogromem nieudanych wdrożeń i w efekcie - źle wydanymi pieniędzmi.

Właśnie to chcę w tym artykule jasno wytłumaczyć prostym językiem.

Ostatnie dwa lata sprawiły, że sztuczna inteligencja zagościła w naszych biurach na dobre. Od menedżerów po specjalistów, wszyscy chcą ją wdrażać, obiecując sobie rewolucję w biznesie. W tym entuzjazmie często dochodzi do pomyłek. Słyszę pytania i stwierdzenia takie jak:

- "Czy ChatGPT to to samo co AI?"

- "Skoro mamy model, to czemu nie może zrobić tego, co chcę?"

- "Niech model uczy się na naszych danych i podejmuje decyzje na bieżąco"

- "Czy nie można po prostu douczyć go, żeby znał naszą firmową wiedzę?"

Największym problemem nie jest technologia, lecz jej niezrozumienie. Ten artykuł ma za zadanie uporządkować podstawowe pojęcia, aby każdy - niezależnie od stanowiska i doświadczenia - mógł świadomie rozmawiać o wdrożeniach AI w swojej firmie.

1. AI to parasol, LLM to jego część, a ChatGPT to gotowy produkt.

To fundamentalna różnica, którą trzeba zrozumieć.

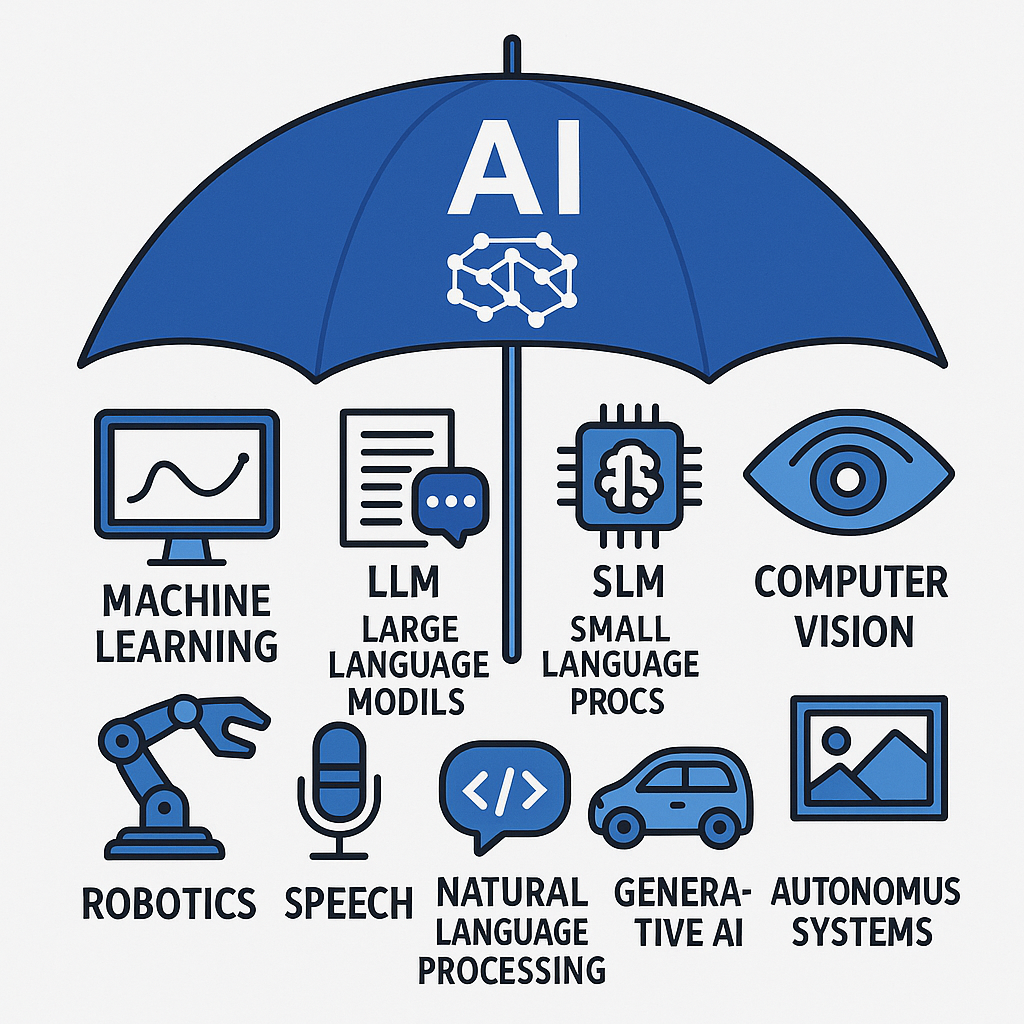

- Sztuczna Inteligencja (AI) to szeroki dział nauki z pogranicza informatyki, neurologii i psychologii. W przyszłości opiszę dokładniej, jak ten "„"sztuczny mózg"”" działa 😉. To parasol, który obejmuje wszystko: od prostych algorytmów rekomendacji (np. na Netflixie) po zaawansowane systemy rozpoznawania mowy, duże modele językowe (czyli LLM, a więc znany wszystkim GPT) oraz modele multimodalne, które poza tekstem rozumieją i generują obrazy i dźwięki.

- Modele Językowe (LLM), takie jak GPT, Gemini, Sonet czy nasz rodzimy Bielik.ai (choć tu mamy SLM, czyli Small Language model - mały model językowy), to jedna z najpotężniej rozwijanych gałęzi AI. Są to "silniki" zdolne do generowania tekstu, kodu czy podsumowywania danych. To surowe, wytrenowane modele, które same w sobie nie są gotową aplikacją, tak jak silnik w samochodzie nie jest jeszcze gotowym autem.

- ChatGPT to natomiast gotowa aplikacja. To produkt, w którym wykorzystano model LLM (czyli ten "silnik"), opakowano go w przyjazny interfejs i udostępniono użytkownikom. To właśnie ta aplikacja sprawiła, że LLM-y stały się popularne.

Ważne: LLM-y to wytrenowane modele. Nie da się ich tanio i łatwo "trenować" pod nasze konkretne potrzeby. Im większy model, tym więcej trzeba włożyć nowych danych, aby choć odrobinę zmienić jego sposób działania.

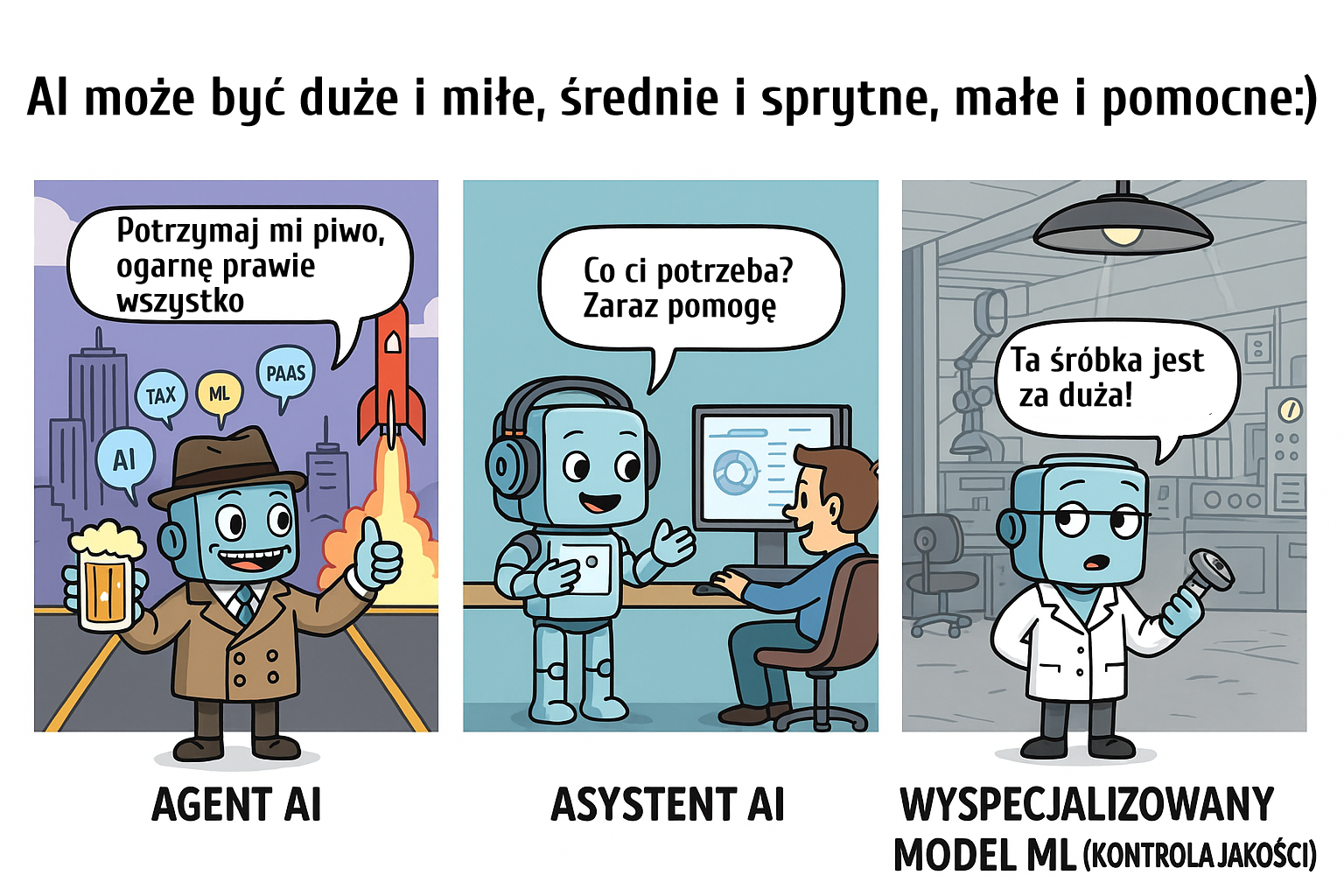

Natomiast techniki uczenia maszynowego (ML) można z powodzeniem wykorzystywać do tworzenia dużo mniejszych, wyspecjalizowanych modeli. Wcześniej wspomniany Netflix uczy się na danych użytkowników, co lubią i co może im się spodobać. To dużo mniejsze ilości danych do nauki niż w przypadku LLM-ów. Można, mając fabrykę i maszyny, analizować na bieżąco dane z ich pracy, aby przewidywać awarie i przestoje oraz działać z wyprzedzeniem. Takie modele tworzą Data Scientists, specjaliści od algorytmów i matematyki, którzy potrafią dobrać odpowiedni sposób nauki do konkretnego przypadku biznesowego. Z tymi modelami nie porozmawiamy.

Podsumowując: AI to cała kategoria, LLM to jej podkategoria, a ChatGPT to konkretny, popularny przykład produktu opartego na LLM.

2. Trening, Fine-Tuning i RAG - trzy różne elementy, które wpływają na "wiedzę" modeli.

To, co potocznie nazywamy "douczaniem AI" w rozumieniu dostarczania wiedzy dla LLM-ów, w rzeczywistości może oznaczać kilka różnych procesów. Wybór odpowiedniego jest kluczowy dla sukcesu projektu.

- Trening od zera (Training): To proces tworzenia modelu od podstaw. Polega na podaniu mu ogromnych, zróżnicowanych danych (terabajty tekstów). Jest to niezwykle drogie i czasochłonne. Modele takie jak GPT czy Gemini powstają w ten sposób. Twoja firma prawdopodobnie nigdy nie będzie trenować modelu LLM od zera.

- Dostrajanie (Fine-Tuning): To proces "douczania" istniejącego modelu na mniejszym, specjalistycznym zbiorze danych zawierającym pary pytań i odpowiedzi. Nie ma to bezpośredniego wpływu na "wiedzę", ale pomaga dostroić styl i sposób, w jaki model odpowiada. Może lekko zmieniać wagi między poszczególnymi neuronami.

- RAG (Retrieval-Augmented Generation): To najbardziej praktyczne rozwiązanie dla większości firm. Zamiast "douczać" model, dostarczamy mu w momencie zapytania dodatkowy, kontekstowy dokument - np. plik PDF z firmową procedurą. Model wykorzystuje ten dokument, aby precyzyjnie odpowiedzieć na pytanie. To tak, jakbyśmy dali mu "ściągawkę" na bieżąco. RAG pozwala używać modeli ogólnych (jak ChatGPT) w kontekście firmowej wiedzy, bez konieczności kosztownego dostrajania.

3. Asystent vs. Agent - więcej niż tylko nazwy.

Kolejny ważny podział to rola, jaką AI pełni w systemie.

- Asystent (Assistant): To rola pasywna. Asystent odpowiada na pytania, generuje tekst, ale zawsze czeka na polecenie od człowieka. Przykładem jest standardowy chatbot.

- Agent (Agent): To rola aktywna. Agent nie tylko odpowiada, ale potrafi też samodzielnie podejmować decyzje i wykonywać szereg akcji. Jego działanie również zaczyna się od jakiegoś wyzwalacza (np. rozkaz użytkownika lub mail, który wpada na naszą skrzynkę), ale agent stara się wykonać zadanie, jakie przed nim postawiono w pętli, i działa, aż je skończy.

Często słyszę o agentach, którzy "dzwonią". Faktycznie, część, która dzwoni i rozmawia, to voicebot (choćby używający LLM-a do rozmowy), ale już decyzja o wykonaniu telefonu i decyzja, co zrobić po nim, to już faktycznie działanie agenta.

4. Współdziałanie z otoczeniem.

Faktycznie, duże modele językowe nie mają innych możliwości niż przyjmowanie pytań i udzielanie odpowiedzi. Wsad może być jednak czymkolwiek - ważne, że jest tekstowy. Aby taki model mógł coś zrobić, używa tak zwanych "tools" (narzędzi), czyli klasycznie oprogramowanych funkcji, które na jego odpowiednią informację i dostarczone przez model parametry coś zrobią (mogą nawet sterować robotem).

Przykład: Wpada nam na skrzynkę mail. Mamy wiele skrzynek i nie mamy czasu ich sprawdzać. Robi to za nas agent. Aplikacja co minutę czyta maile. Gdy nowy mail wpada, jego treść w formie wsadu jest wysyłana do modelu AI/LLM. Ten ma informację systemową, tzw. prompt systemowy, który brzmi np.: "Gdy w mailu jest zapytanie ofertowe, odpowiedz, używając funkcji mail_odpowiedz, że wkrótce oferta zostanie wysłana, oraz użyj funkcji przelij_mail, aby przesłać informację do mnie na chat." I on, korzystając z tych funkcji, właśnie te czynności wykonuje.

Podsumowanie

Zrozumienie tych różnic to pierwszy krok do budowania strategicznej architektury systemów IT, która faktycznie przyniesie korzyści Twojej firmie. AI to nie magia, ale zaawansowane narzędzie, którego potencjał uwalnia się dopiero wtedy, gdy wiemy, jak je poprawnie zastosować.

Zamiast pytać: "Czy AI może to zrobić?", powinniśmy pytać: "Jaki model, w jakiej architekturze i w jakim produkcie najlepiej rozwiąże nasz konkretny problem?". Ta zmiana perspektywy to klucz do sukcesu w erze cyfrowej.

0 Komentarzy